こんにちは、JS2IIUです。

Pythonエンジニアの間で、データ分析アプリやAIデモを素早く構築するための標準ツールとなったStreamlit。その進化は止まることを知らず、2025年の最新アップデートの一つであるバージョン1.52.0において、非常に重要な機能改善が行われました。

今回スポットを当てるのは、ファイルのダウンロード機能を提供する st.download_button です。これまで、このウィジェットは「非常に便利だが、大規模なデータを扱う際にはパフォーマンスのボトルネックになりやすい」という課題を抱えていました。しかし、v1.52.0で導入された「データ生成の遅延評価(Lazy Evaluation)」により、その問題が解決されました。

本記事では、この新機能がなぜ画期的なのか、そして具体的にどのようにコードを書けば、あなたのアプリをより軽く、スマートにできるのかを、PythonとPyTorchの実装例を交えて詳しく解説します。今回もよろしくお願いします。

1. これまでの課題:なぜ従来の st.download_button は重かったのか

Streamlitは、ユーザーが画面上のウィジェットを操作するたびに、スクリプト全体を上から下まで再実行するという特性を持っています。これにより、コードの状態管理が簡素化される一方で、重い処理が含まれる場合にパフォーマンスの問題が生じます。

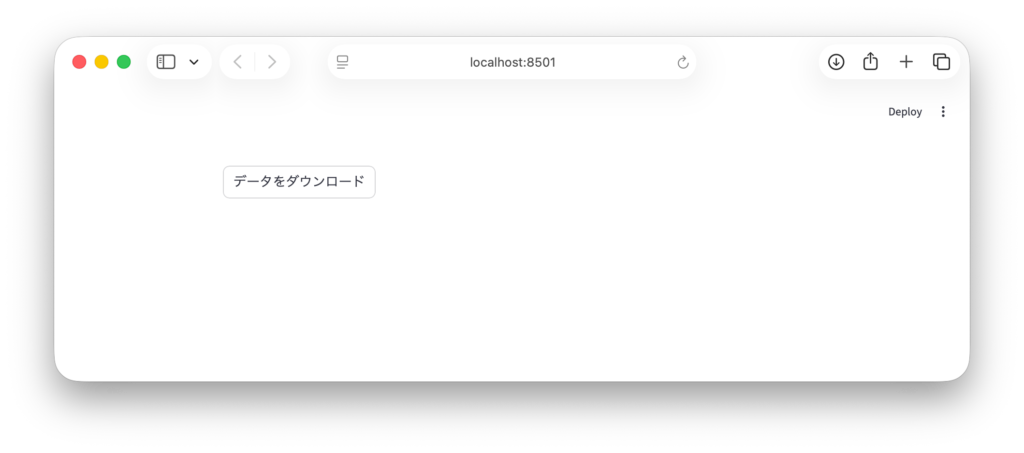

従来の st.download_button の定義は以下の通りでした。

# 旧バージョン(v1.51.0以前)のイメージ

st.download_button(

label="データをダウンロード",

data=heavy_data_processing(), # ここで即座に関数が実行される

file_name="result.csv"

)

このコードの問題点は、ユーザーがダウンロードボタンを押すかどうかにかかわらず、スクリプトが実行されるたびに heavy_data_processing() が呼び出されてしまうことです。

例えば、100MBのCSVファイルを生成する処理や、学習済みのAIモデルをバッファに書き出す処理がある場合、ユーザーがただ画面のチェックボックスを一つ動かしただけで、背後では巨大なデータの生成とメモリへの展開が繰り返されていました。これは、サーバーリソースの無駄遣いであるだけでなく、アプリの応答性を著しく低下させる要因となっていました。

2. v1.52.0の新機能:データ生成の「遅延評価(Lazy Evaluation)」

Streamlit 1.52.0では、st.download_button の data 引数に、「データを返す関数そのもの(Callable)」を渡せるようになりました。

これにより、データの生成プロセスが「遅延評価」されます。つまり、ユーザーが実際にボタンをクリックしたその瞬間まで、重い処理は実行されません。

概念的な違いを比較してみましょう。

従来の方式では、アプリの実行時間を \( T \) とし、データ生成時間を \( T_{gen} \)、その他の描画時間を \( T_{ui} \) とすると、毎回の再実行で \( T = T_{gen} + T_{ui} \) の時間がかかっていました。

新機能を利用すると、通常の再実行時は \( T = T_{ui} \) となり、ダウンロード時のみ \( T = T_{gen} + T_{ui} \) となります。この差は、特にデータ量が多い場合に劇的なパフォーマンス向上をもたらします。

3. 【実践】基本的な実装方法

それでは、具体的な実装方法を見ていきましょう。まずは、最もシンプルなテキストデータをオンデマンドで生成する例です。

import streamlit as st

import time

def generate_text_data():

# データの生成をシミュレート(重い処理)

time.sleep(2)

return "これはオンデマンドで生成されたテキストデータです。"

st.title("Streamlit 1.52.0 新機能デモ")

# 新しい方法:dataに関数名を渡す(括弧をつけないことに注意)

st.download_button(

label="テキストを生成してダウンロード",

data=generate_text_data, # 関数をそのまま渡す

file_name="lazy_text.txt",

mime="text/plain"

)

st.write("ボタンを押すまで、generate_text_data() は実行されません。")

上記のコードにおいて、data=generate_text_data と記述している点に注目してください。ここで generate_text_data() (括弧あり)と書いてしまうと、その場で実行されてしまい、従来と同じ動作になります。関数オブジェクトをそのまま渡すことで、Streamlit側が必要な時(クリック時)にのみその関数を呼び出してくれるようになります。

4. 【応用】データサイエンス・AI開発での活用シーン

この新機能は、特にリソース消費の激しいAI・機械学習のワークフローにおいて真価を発揮します。ここでは2つの具体的なシナリオを紹介します。

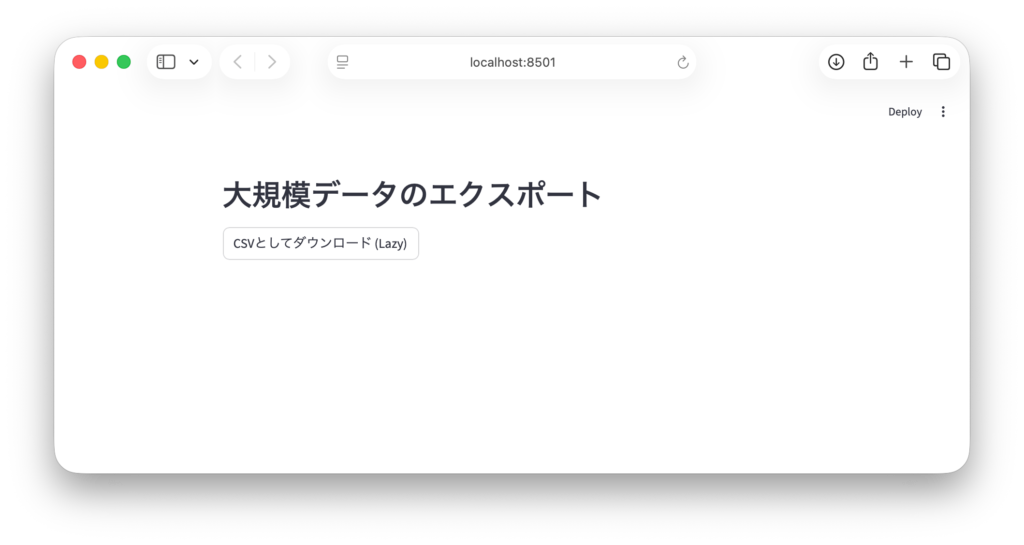

シーン1:大規模なPandas DataFrameのCSV変換

データ分析アプリでは、フィルタリングされた結果をCSVでダウンロードさせることがよくあります。

import streamlit as st

import pandas as pd

import numpy as np

def get_large_dataframe():

# 巨大なダミーデータの作成

df = pd.DataFrame(

np.random.randn(100000, 10),

columns=[f'Col {i}' for i in range(10)]

)

# CSV形式の文字列に変換(この処理が重い)

return df.to_csv(index=False).encode('utf-8')

st.header("大規模データのエクスポート")

# 1.52.0以前:ページ読み込みのたびにCSV変換が走る

# 1.52.0以降:クリック時のみ変換が走る

st.download_button(

label="CSVとしてダウンロード (Lazy)",

data=get_large_dataframe,

file_name="large_data.csv",

mime="text/csv"

)

この実装により、ユーザーがデータを閲覧・操作している間はCPUやメモリを節約し、本当にファイルが必要になった時だけ計算リソースを集中させることができます。

シーン2:PyTorchモデルの重みファイルのダウンロード

AIエンジニアにとって非常に便利なのが、モデルのチェックポイントを動的に作成して提供するケースです。例えば、ユーザーがパラメータを選択してファインチューニングを行った後、その結果をダウンロードさせる場面を想定します。

import streamlit as st

import torch

import torch.nn as nn

import io

class SimpleModel(nn.Module):

def __init__(self, input_dim):

super(SimpleModel, self).__init__()

self.fc = nn.Linear(input_dim, 1)

def forward(self, x):

return self.fc(x)

def serialize_model():

# PyTorchモデルの初期化

# 実際にはここで学習済みの重みをロードするなどの処理が入る

model = SimpleModel(input_dim=10)

# バッファにモデルを保存

buffer = io.BytesIO()

torch.save(model.state_dict(), buffer)

# バッファの先頭に戻って値を返す

return buffer.getvalue()

st.header("AIモデル・エクスポート")

# ユーザーがハイパーパラメータを変更するたびにモデルを再構築・シリアライズするのは非効率

# そのため、この新機能が非常に有効

st.download_button(

label="学習済みモデル(pthファイル)を保存",

data=serialize_model,

file_name="model_weights.pth",

mime="application/octet-stream"

)PyTorchの state_dict の保存処理などは、モデルの規模が大きくなると無視できない時間がかかります。これを遅延評価にすることで、UIのレスポンスを犠牲にすることなく、シームレスなモデル配布が可能になります。

5. 実装時の注意点とベストプラクティス

非常に強力な新機能ですが、利用にあたってはいくつかのポイントを押さえておく必要があります。

1. 関数の引数についてdata 引数に渡す関数は、引数を取らないものである必要があります。もし特定の状態に基づいたデータを生成したい場合は、Pythonの functools.partial を使うか、クロージャを利用して値をラップします。

from functools import partial

def generate_custom_data(user_id):

return f"User {user_id} のレポート".encode()

# partialを使って引数を固定した関数を作成

download_func = partial(generate_custom_data, user_id=123)

st.download_button("レポート取得", data=download_func, file_name="report.txt")2. ユーザーへのフィードバック

遅延評価を行うと、ボタンをクリックしてからダウンロードが始まるまでに計算時間がかかります。あまりに処理が重い場合、ユーザーは「ボタンが効いていない」と感じるかもしれません。生成関数の中で st.spinner を使いたいところですが、download_button のコールバック内でのUI更新には制限があるため、あらかじめ「生成には時間がかかります」といった注意書きを添えるなどの工夫が推奨されます。

3. キャッシュとの組み合わせ

もし同じデータを何度も生成する可能性があるなら、@st.cache_data を検討してください。ただし、メモリを節約したいという今回の趣旨であれば、キャッシュせずに毎回生成する(遅延評価する)方が、サーバーのRAM消費を抑えられるという側面もあります。

6. まとめ

Streamlit 1.52.0で導入された st.download_button のアップデートは、一見地味ながらも、大規模なデータやAIモデルを扱うプロフェッショナルなアプリ開発においては「待望」と言える改善でした。

- 効率性: 不要な計算を排除し、サーバーリソースを最適化。

- 快適性: UIの再実行がスムーズになり、UX(ユーザーエクスペリエンス)が向上。

- 柔軟性: 関数を渡すだけで、動的なコンテンツ生成を簡潔に記述可能。

これまでは、ダウンロードデータの事前生成を回避するために、セッション状態(st.session_state)を駆使した複雑な回避策を講じていた方も多いでしょう。これからは、このスマートな「遅延評価」を活用して、より洗練されたPythonアプリを構築していきましょう。

最後まで読んでいただきありがとうございます。

コメント